Neuromarketing y estudio de expresiones faciales de emociones

Escrito por Sergio Orosco Morales, Arturo Corona Ferreira, Carlos Arturo Custodio Izquierdo y Carlos González Zacarías

Resumen

El reconocimiento facial y la identificación de emociones en la interacción humano-máquina mejora las soluciones informáticas. Desde el siglo XX, en neuromarketing se explora cómo el reconocimiento facial y la comprensión de emociones han evolucionado, desde el trabajo de Ekman hasta el uso de tecnologías como la inteligencia artificial. Gracias al uso de técnicas de neurociencia y tecnologías de la información, es posible comprender mejor el comportamiento humano, especialmente en el contexto del marketing. Para hacer uso de esta tecnologías se deben involucrar ciencias como la psicología, la informática y la neurociencia. Adicionalmente, con el uso de herramientoas digitales es posible el reconocimiento facial. La comprensión de emociones en diversas aplicaciones favorece el uso de tecnologías que pueden ser utilizadas para entender mejor el comportamiento humano y mejorar la experiencia del usuario en entornos digitales.

Palabras clave: neuromarketing, herramienta digital, emociones.

Introducción

Las emociones y el comportamiento humano

La identificación y la catalogación de las emociones tienen especial importancia en el campo de la interacción hombre-máquina, afirma Erro (2010), investigador que sustenta que este tipo de precisiones puede permitir mejorar la calidad de las soluciones informáticas, al proporcionar un parámetro del estado emocional del usuario.

Desde principios del siglo XX, diversos investigadores han realizado análisis de las expresiones faciales. Pérez-Rincón, Cortés y Díaz-Martínez (1999) plantean que el reconocimiento de expresiones faciales de las emociones es uno de los temas centrales de la comunicación extraverbal y está presente en la investigación y la reflexión psicológicas desde hace 2300 años.

Uno de los primeros trabajos sobre reconocimiento facial de las emociones se identifica en el terreno de la psicología, donde Bruner y Tagiuri (1954) reconocen la existencia de conjuntos de expresiones faciales provenientes de estados fisiológicos. En lo que respecta a los sistemas de software que reconocen el rostro y sus emociones, Bledsoe (1964) presenta que los primeros esfuerzos de construcción de catálogos de emociones se dieron a mediados de los años sesenta. Cuve y Maia (2016) manifiestan que hay evidencias de trabajos similares de Charles Darwin en 1872, los cuales sentaron las bases conceptuales para la identificación de patrones de emociones. Ekman y otros (1972) plantean que mientras las voces y el habla son formas de comunicación intermitentes, los rostros humanos son informativos incluso en reposo, ya que la cara es el lugar de entrada sensorial, de captación vital y de salida comunicativa. Las expresiones faciales son manifestadas como reacciones fisiológicas producto de la recepción del contexto, donde se alojan el gusto, el olfato, la visión y el oído; es el órgano receptor de los alimentos, el agua y el aire, y la parte de salida del lenguaje; asimismo, formula un tipo de comunicación por la forma misma del rostro.

Ekman es el referente del siglo XX, ya que su teoría ha sido sustentada desde diversos trabajos que dan forma a las seis emociones básicas: felicidad, tristeza, ira, asco, sorpresa y miedo (Ekman, Friesen, Wallace y Ancoli, 1972). Los trabajos de Ekman concentran las bases de la psicología para la construcción de desarrollo de software, que buscan sistematizar el proceso de organización y estructuración de datos de emociones, los cuales son de naturaleza multimodal por ser información proveniente de la fisiología humana, lo que permite construir de manera precisa datos sobre el comportamiento humano en contextos diversos, los cuales, gracias a la inteligencia artificial de hoy día, se pueden aplicar en diversos contextos.

Damasio (citado en Ramos, 2012) planteó la importancia de la emoción en la toma de decisiones, oponiéndose a la idea de que la emoción es una distracción que debe ser suprimida para tomar una decisión adecuada, lo que lleva a reflexionar que la emoción está altamente correlacionada con los procesos de memoria, aprendizaje, fuerza de atención y lenguaje. Damasio definió la emoción como un conjunto complejo de respuestas fisiológicas y conductuales, generalmente de corta duración, dependientes de la activación de ciertos sistemas cerebrales que responden a algún evento externo o interno que ha sido empujado con anterioridad.

Desde 1975, investigadores en psicofísica, ciencias neuronales e ingeniería, procesamiento de imágenes e informática han trabajado sobre una serie de problemas relacionados con el reconocimiento facial por humanos y máquinas. En los últimos años, el reconocimiento facial ha recibido una atención sustancial de los investigadores en biometría, reconocimiento de patrones y comunidades de visión por computadora. El aprendizaje automático, la computadora y las comunidades gráficas también están cada vez más involucradas en el reconocimiento facial.

Existen evidencias, como las presentadas por Serrano, Conde y Cabello (2006), de que, apoyados en recursos tecnológicos como la electroencefalografía, el análisis de la voz y el reconocimiento facial con la ayuda de cámaras de video, se han acelerado los acercamientos por medio de tecnologías para un mejor entendimiento de las emociones en diversos contextos. Desde otra perspectiva, Espinoza y Gallegos (2018) identificaron 20 artículos que tratan sobre aplicaciones de reconocimiento facial basadas en emociones, siendo las principales áreas de aplicación la medicina, la educación y los negocios, donde las campañas de neuromarketing se ajustan a estas últimas.

Neuromarketing

Bagozzi et al. (1999) plantean ciertas bases sobre la importancia del reconocimiento de los estados emocionales para los vendedores y Brown et al. (1997) afirman la influencia de las emociones sobre el comportamiento y el rendimiento específicamente de los profesionales en ventas. Estas dos nociones acerca de la relación entre rendimiento en procesos de ventas y emociones se vuelve un carácter central para la integración de la inteligencia emocional en la formación en ventas.

Kuster y Vila (2015) reconocen que existen diversos esfuerzos en el ámbito del neuromarketing al usar y desarrollar productos que permiten conocer el comportamiento de los consumidores por medio de una clasificación facial de las emociones. Alonso (citado en Kuster y Vila, 2015) propone que el neuromarketing es un recurso ampliamente utilizado para investigar el comportamiento del consumidor en este siglo XXI, ya que integra el uso de recursos tecnológicos que captan información fisiológica y los correlaciona con distintas tareas que realiza un usuario.

Una revisión sistemática de literatura mapeada para investigar sobre aplicaciones de neuromarketing a través de recursos de reconocimiento facial, en la mayoría de los artículos revisados por Espinoza y Gallegos (2018), no logró identificar información específica sobre el marco de referencia y encontró pocos artículos de neuromarketing útiles para el análisis de reconocimiento facial. Estos hechos permiten sustentar el gran interés en el uso del reconocimiento facial para estudiar el comportamiento humano y que el trabajo de investigación propuesto será de gran valor.

“Neuromarketing es un campo interdisciplinario que aplica las nuevas técnicas de neuroimagen para identificar sustratos neurales implicados en las decisiones y el comportamiento del consumidor”, esto por medio de herramientas tecnológicas diseñadas para guiar más objetivamente las capacidades cognitivas e intencionales de los consumidores frente a las ofertas de marketing (Coca Carasila, 2010).

Al neuromarketing lo definen Droulers y Roullet (citados en Coca Casasila, 2010) como el estudio de los procesos mentales, explícitos e implícitos, y el comportamiento del consumidor en diversos contextos, tanto en las actividades de marketing para la evaluación, la toma de decisiones, el almacenamiento o consumo, basado en los paradigmas y el conocimiento de la neurociencia.

El primer estudio de neuromarketing se llevó a cabo por el profesor de neurociencia Read Montague en Baylor College of Medicine en 2003 y fue publicado en la revista Neuron un año más tarde (Oriol, 2014).

El neuromarketing es de carácter multidimensional, proponen Foxall, Goldsmith y Brown Kuster y Vila (2015), ya que involucra las emociones con la motivación de toma de decisiones que realiza cada individuo, ya sea por necesidades personales básicas o necesidades biológicas; por interacciones sociales entre diferentes individuos o necesidades sociales, de supervivencia y de bienestar.

Al aplicar las neurociencias a experimentos contextualizados, es posible identificar un estado provocado o bien comprender las causas que ocasiona llegar a una emoción o motivación. Duque (2014) propone que la aplicación de las técnicas de neurociencias a contextos de mercadotecnia puede ser llamada neuromarketing, ya que permite mapear con información proveniente del contexto biológico del ser un proceso de toma de decisiones, ya sea de experiencia de servicio o de compra; esto puede ayudar a conocer o describir mejor a los clientes, donde las técnicas de neurociencias tienen la intención de describir las causas que ocasiona tomar una decisión o que provocan una emoción.

Los seres humanos, por naturaleza, exteriorizan las emociones por medio de expresiones faciales; es por ello que desarrollar un servicio de análisis de emociones requiere el uso de una cámara enfocada al rostro. Según Du Plessis (citado en Sebastian, 2014), la medición de las reacciones fisiológicas a los estímulos de marketing de un sujeto consumidor es un método indirecto de medición de la toma de decisiones a nivel de la corteza cerebral. Este tipo de métodos revela aspectos relacionados con la emoción del consumidor, en relación con elementos estructurales que definen la amígdala. Sin embargo, estos métodos no son tan fiables.

Dado que el neuromarketing se apoya en recursos tecnológicos que permiten describir fisiológicamente el comportamiento humano, Cárdenas (2019) propone que cualquier ciencia o disciplina que ayude a comprender mejor los procesos cognitivos y conductuales del ser humano puede ser de utilidad para el neuromarketing, lo que sumado a las herramientas médicas de análisis, permite una mayor comprensión y uso de esta disciplina en el camino a convertirse en una ciencia autónoma.

Método

Desde el campo de la tecnología de la información, el reconocimiento facial se ha convertido en un foco de investigación. Este campo considera disciplinas tales como el procesamiento de imágenes, el reconocimiento de patrones, la visión artificial y las redes neuronales.

Adicionalmente, es un área de trabajo multidisciplinar donde se requiere que expertos en psicología, neurociencia e informática estén involucrados en el proceso de investigación, porque son expertos en el campo del reconocimiento de objetos, donde un rostro humano se convierte en un objeto 3D que cambia dependiendo de cómo cambia la imagen, un cambio de iluminación, pose o posición, ya que se puede identificar con base en su proyección 2D, excepto cuando se utiliza tecnología 3D.

El objetivo principal de un sistema de reconocimiento facial es detectar, a partir de cualquier imagen de un rostro o una imagen utilizada como prueba, para encontrar una imagen con las mismas características en la biblioteca de imágenes, la dificultad es que el resultado puede ser en tiempo real, por lo que el sistema debe identificar automáticamente la imagen o video del rostro que existe.

El campo del reconocimiento facial ha existido desde mediados del siglo XX; el primer sistema automatizado que utiliza reconocimiento facial se desarrolló en 1977. Cabe destacar que un sistema de reconocimiento facial no siempre es confiable, especialmente al variar circunstancias tales como expresión, pose e iluminación.

Investigaciones recientes han demostrado que los algoritmos de reconocimiento facial 3D permiten trabajar con cámaras de baja resolución o webcams. La codificación de las webcams se basa en datos completos que requieren cantidades poco prácticas de almacenamiento para un sistema real.

Este interés común entre los investigadores que trabajan en diversos campos está motivado por nuestra notable capacidad para reconocer a las personas y el hecho de que la actividad humana es una preocupación principal tanto en la vida cotidiana como en el ciberespacio.

Las técnicas de reconocimiento facial se pueden dividir en dos grupos o familias, las cuales están basadas en modelos de apariencia y en modelos. En cada uno de estos grupos o familias se encuentran varios métodos para visualizar la imagen. Los sistemas basados en reconocimiento de apariencia trabajan directamente en imágenes sin usar modelos 3D, por otro lado, los sistemas basados en modelos intentan construir tantas descripciones de rostros como sea posible, y son capaces de capturar con precisión los cambios que aparecen en los rostros.

Las emociones se pueden dividir en varias categorías principales, específicamente, las seis emociones son felicidad, sorpresa, miedo, disgusto, ira, tristeza. Para codificar las expresiones faciales, se ha desarrollado un sistema de codificación de acción facial (FACS), en el que los movimientos faciales se describen mediante variables relacionadas con el movimiento muscular. El trabajo de Ekman ha inspirado a un gran número de investigadores en ciencias computacionales, especialmente en el campo del análisis de expresiones faciales de imágenes y videos. Las seis grandes emociones definidas anteriormente se consideran básicas o elementales porque de ellas se pueden derivar todas las demás emociones.

Para que las emociones sean información que los sistemas informáticos puedan usar, se necesita un modelo que reconozca las emociones. Aunque algunas obras realizan este proceso de forma individual, en comparación con los sistemas de reconocimiento de emociones monomodales, los métodos multimodales pueden modelar las emociones del usuario con mayor precisión.

“Un reconocimiento multimodal es una aproximación de la inteligencia artificial para darle la capacidad a un modelo de procesar y relacionar información de múltiples modalidades para discriminar y clasificar información” (Barrón, Cárdenas y Zatarain, 2019).

El sistema de reconocimiento multimodal se utiliza para conocer las emociones como felicidad, tristeza, ira, miedo y sorpresa en función de los eventos presentes; todo el proceso consiste en capturar eventos desde un enfoque multimodal. Dentro de este bloque se identifican expresiones faciales de secuencias de imágenes y video, factores acústicos como tono de voz, intensidad y velocidad, así como aspectos de lenguaje corporal, por ejemplo secuencia de imágenes, video que determina la posición de brazos, cabeza, puños y otros gestos (Aguilar y Cordero, 2016).

Desarrollo

Problemática

Uno de los principales problemas hoy en día es la capacidad de representar los estados de las emociones; identificarlas es primordial, ya que aportan datos necesarios para la toma de decisiones y para realizar nuestra actividad diaria.

Lawler (1999) define las emociones como “estados evaluativos, sean positivos o negativos, relativamente breves, que tienen elementos fisiológicos, neurológicos y cognitivos”.

Se pretende desarrollar un sistema tecnológico que permita identificar las expresiones faciales de un individuo, algunas de las emociones que se intentan detectar son tristeza, enojo, sorpresa y felicidad. Esta aplicación permitirá reconocer las emociones a través de las expresiones del rostro por medio de movimientos musculares. Las emociones se pueden medir en micro y macroexpresiones, las cuales solo difieren en su duración. Las microexpresiones tienen una duración tan corta que la duración que marca la diferencia entre sujetos capaces y no capaces de detectarlas supondría el punto del corte que separa las micros de las macroexpresiones faciales: las microexpresiones duran menos de medio segundo y las macroexpresiones son las que duran más de medio segundo (Leonte, 2019).

Por naturaleza, los seres humanos demuestran sus emociones por medio de expresiones faciales; es por ello que desarrollar un servicio de análisis de emociones requiere el uso de una cámara enfocada al rostro. Según Du Plessis (citado en Sebastian, 2014), la medición de las reacciones fisiológicas a los estímulos de marketing de un sujeto consumidor es otro método indirecto de medición de la toma de decisiones a nivel de la corteza cerebral. Este tipo de métodos revela aspectos relacionados con la emoción del consumidor en relación con elementos estructurales que definen la amígdala. Sin embargo, estos métodos no son tan fiables.

Tecnología y neurociencias

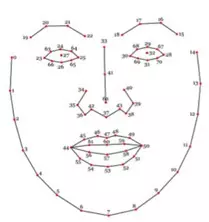

Saragih, Lucey y Cohn (2009), creadores del algoritmo de deformación Clmtrackr, plantean que el principio bajo el cual opera este algoritmo es mediante la deformación vectorial de una máscara construida con setenta puntos de referencia, esto es, a partir de una primera imagen que reconoce la cámara, construye una referencia como punto de partida.

Por otro lado, la malla de referencia y los estados de emoción fueron creados con datos de entrenamiento bajo un modelo MUCT de base de datos, en el cual, de acuerdo con Milborrow, Morkel y Nicolls (2010), se creó un patrón de datos de referencia provenientes de 3755 imágenes de rostros humanos con 76 puntos marcados de forma manual. Dicho modelo funciona como un modelo entrenado de forma activa, dando como resultado un modelo flexible.

Resultados

Al crear una solución utilizando Clmtrackr de Auduno, se pueden crear conjuntos de datos JSON casi directamente para aplicar análisis de usabilidad del sitio web, mediante técnicas de neurociencia, es decir, puede guiar estudios de usabilidad, los cuales permiten tener nuevos entendimientos sobre la experiencia de usuario al acceder a sitios web. Esto es posible para cualquier escenario, ya sea comercial, educativo o empresarial, brindando así la apertura para crear conocimiento nuevo sobre experiencias de aprendizaje, experiencias de compra o bien experiencias en entornos web de colaboración empresarial, donde las reacciones de cada usuario pueden ser colectadas en ambientes controlados o mediante el apoyo de participantes voluntarios que permitan que sean capturadas sus reacciones mientras navegan y visitan un sitio web, donde los resultados de las emociones puedan llegar a correlacionar el recorrido en cada página y donde las tareas que se realicen puedan ser identificadas desde una perspectiva de las emociones, y así sustentar la viabilidad o rediseño de recursos web sin necesidad de aplicar cuestionarios o colocar sensores fisiológicos de manera cutánea a cada participante.

Este tipo de investigación asume que cualquier usuario expresa sus emociones internas a través de expresiones faciales al interactuar con una página web, por lo que la investigación de neuromarketing se puede realizar con cualquier usuario al interactuar con un sitio web. Los conjuntos de datos generados a través de estudios de usabilidad bajo el modelo GOMS u otros modelos pueden ser analizados o interpretados por herramientas externas de análisis de datos, que requieren una participación multidisciplinaria experta en el diseño y la investigación del sitio web para construir en conjunto las interpretaciones representadas en la herramienta.

Discusión

De acuerdo con Corona, Altamirano y López (2021), en los contextos actuales las neurociencias y las tecnologías de la información han evolucionado a tal grado, que se apoyan mutuamente para un mejor entendimiento de lo que sucede a nivel cognitivo en el cerebro mediante la identificación de las señales fisiológicas que se generan por los estímulos de motivación y emociones. De manera concreta, este artículo se enfoca en describir una propuesta de servicio web de reconocimiento facial para el análisis de emociones a usuarios que acceden a un sitio web, el cual se puede aplicar de forma local o remota.

Al realizar una búsqueda de soluciones para el estudio de expresiones faciales en github.com, se identifican 149 proyectos desarrollados con tecnología Javascript y 1254 desarrollados con tecnología Python. En específico en este artículo se presentan resultados del trabajo con la librería Clmtrackr de Auduno, disponible en https://github.com/auduno/clmtrackr (Ordoñez, Pazmiño y Domínguez, 2016), el cual cuenta con los recursos para construir conjuntos de datos de las emociones de enojo, disgusto, miedo, sorpresa y alegría en estructura JSON. Estos datos se crean por medio de la lectura de deformación de 70 puntos faciales.

Una versatilidad de esta aplicación es que tiene el atributo de poderse instalar y configurar en cualquier servidor web, ya sea en un servicio de hosting o máquina virtual. Espinoza y Gallegos (2018), mediante una revisión sistemática literaria, reportan 14 herramientas de software de reconocimiento facial enfocadas de manera específica al neuromarketing.

Uno de los recursos que se identifica de manera recurrente es aplicar una malla de modelo de expresión creado a partir de los contornos del rostro, donde se genera una malla de referencia para los estados de emoción. El primer trabajo que fundamenta con datos de entrenamiento de inteligencia artificial fue el realizado por Milborrow, Morkel, y Nicolls (2010), donde los autores proponen un modelo denominado MUCT, el cual construye una base de datos con valores, que crea un patrón de datos de referencia provenientes de 3755 imágenes de rostros humanos, los cuales dan referencia de 76 puntos marcados de forma manual. Dicho modelo funciona como un modelo entrenado de forma activa, dando como resultado un modelo flexible, que mide los cambios a partir de un modelo original.

Los trabajos de Milborrow, Morkel, y Nicolls (2010) dan sustento al modelo de Saragih, Lucey y Cohn (2009) y le dan la validez para ser utilizado como recurso de clasificación de los seis estados de emoción de Ekman.

Conclusión

Para lograr buenos resultados con las soluciones de expresión facial en la detección de emociones, es necesario tener un plan de exploración del sitio web, que puede estimular las emociones del usuario a través de cada una de las páginas y sus contenidos.

Al interactuar con una página web, el usuario manifiesta sus emociones internas; es aquí donde las expresiones faciales abren un canal de datos que propicia un estudio de neuromarketing. Los conjuntos de datos generados son producto del estudio debido a los pasos secuenciales. El uso de una página web debe llevar a completar tareas como leer la página haciendo clic en los botones y prestando atención a la exploración del contenido de un sitio web.

Al mismo tiempo que el usuario realiza su actividad usando un navegador web o una aplicación de escritorio, la cámara web tiene la capacidad de capturar la expresión emocional cada tres segundos, donde las emociones identificadas permiten construir conjuntos de datos que luego pueden ser analizados o interpretados mediante analíticas de datos, apoyados de herramientas como dashboards, donde la participación multidisciplinar de expertos en diseño web y el estudio del comportamiento humano por parte de psicólogos, docentes o cognitivistas construyen interpretaciones mediante la lectura de gráficas estadísticas representadas en una herramienta.

La solución final que propone este proyecto fue creada con el Clmtrackr de Auduno, donde los datos de salida son en formato JSON y son leídos por un dashboard que representa los datos para construir interpretaciones, las cuales formulan un conocimiento nuevo sobre productos de software al utilizarlo usuarios reales o usuarios potenciales.

Referencias

- Aguilar, J. y Cordero, J. (2016). Reconocimiento multimodal de emociones en un entorno inteligente basado en crónicas. https://www.researchgate.net/publication/307888062_Reconocimiento_multimodal_de_emociones_en_un_entorno_inteligente_basado_en_cronicas

- Barrón, M. L., Cárdenas, H. M. y Zatarain, R. (2019). Reconocimiento multimodal de emociones orientadas al aprendizaje. Instituto Tecnológico de Culiacán, 153-165. https://www.rcs.cic.ipn.mx/2019_148_7/Reconocimiento%20multimodal%20de%20emociones%20orientadas%20al%20aprendizaje.pdf

- Cárdenas, G. G. (2019). “El neuromarketing, como herramienta efectiva para la educación en las ventas y la publicidad”. Revista Latina de Comunicación Social, (74), 1173-1189.

- Coca Carasila, A. M. (2010). “Neuromarketing: las emociones y el comportamiento de compra”. Perspectivas, (25), 9-24. https://www.redalyc.org/articulo.oa?id=425942454003

- Corona Ferreira, A., Altamirano Santiago, M. y López Ortega, M. Á. (2021). “Empleo de dispositivos BCI en alumnos para la evaluación docente RIED”. Revista Iberoamericana de Educación a Distancia, 24 (1). Asociación Iberoamericana de Educación Superior a Distancia. https://www.redalyc.org/articulo.oa?id=331464460015. DOI: https://doi.org/10.5944/ried.24.1.27502

- Cuve, H. C. J. & Maia, L. (2016). A neuro (psychological) approach for emotion recognition deficits in depression. Cuadernos de Neuropsicología/Panamerican Journal of Neuropsychology, 10(3).

- Duque Oliva, E. J. D. (2014). “Neuromarketing: Una nueva frontera”. Suma de negocios, 5(12), 75. http://dx.doi.org/10.1016/j.neucir.2013.12.001

- Hernández Fernández, A. (2015). Factores que influyen en la compra y consumo de bebidas: alcohol vs. no alcohol [tesis doctoral]. Programa de Doctorado Interuniversitario en Marketing. Departamento de Comercialización e Investigación de Mercados. Universidad de Valencia.

- Lawler, E. J. (1999). Bringing emotions into social exchange theory. Annual Review of Sociology, 25, 217-244.

- Leonte, A. (2019). Efectos de la duración de las expresiones faciales en la detección de las microexpresiones. Club de Lenguaje No Verbal. https://www.comportamientonoverbal.com/clublenguajenoverbal/efectos-de-la-duracion-de-las-expresiones-faciales-en-la-deteccion-de-las-microexpresiones-club-de-lenguaje-no-verbal/

- Milborrow, S., Morkel, J. & Nicolls, F. (2010). The MUCT landmarked face database. Pattern recognition association of South Africa, 201(0).

- Nicu Sebe, I. C. & Huang, T. S. (2004, June 18). Multimodal Emotion Recognition, University of Amsterdam. The Netherlands.

- Ordoñez, M. M. C., Pazmiño, C. I. P. & Domínguez, E. C. S. (s/f). Uso de las TIC en la recolección de información. https://www.pedagogia.edu.ec/public/docs/3d54557ddd9a50c97423cb7c7 713636b.pdf

- Oriol Cebreros, A. D. (2014). El análisis de la expresión facial como herramienta del neuromarketing: utilidad y probabilidades de éxito.

- Pérez-Rincón, H., Cortés, J. y Díaz-Martínez, A. (1999). “El reconocimiento de la expresión facial de las emociones”. Salud Mental, 22(1), 17-23.

- Ramos, J. (2012). Psicobiología del procesamiento emocional. Tendencias Actuales de las neurociencias cognitivas (2.ª edición). Instituto de Neurociencias-CUCBA Universidad de Guadalajara. http://tiny.cc/jlxopz

- Revina, I. M. & Emmanuel, W. R. S. (2018). A survey on human face expression recognition techniques. Journal of King Saud University – Computer and Information Sciences. doi:10.1016/j.jksuci.2018.09.002

- Santoya Montes, Y., Garcés Prettel, M. y Tezón Boutureira, M. (2018). Las emociones en la vida universitaria: análisis de la relación entre autoconocimiento emocional y autorregulación emocional en adolescentes y jóvenes universitarios. Psicogente, 21(40), 168-185. https://doi.org/10.17081/psico.21.40.3081

- Saragih, J. M., Lucey, S. & Cohn, J. F. (2009). Face alignment through subspace constrained mean-shifts. In IEEE 12th International Conference on Computer Vision (1034-1041). https://ieeexplore.ieee.org/abstract/document/5459377

- Sebastian, V. (2014). Neuromarketing and evaluation of cognitive and emotional responses of consumers to marketing stimuli. Procedia-Social and Behavioral Sciences, 127, 753-757. doi:10.1016/j.sbspro.2014.03.349

- Serrano Diego, I. M., Conde, C. y Cabello, E. (2006, diciembre). “Técnicas de reconocimiento automático de emociones”. Teoría de la Educación. Educación y Cultura en la Sociedad de la Información, 7(2), 107-127. Universidad de Salamanca.

- Sumathi C. P., Santhanam, T. & Mahadevi, M. (2012, diciembre). Automatic Facial Expression Analysis A Survey. International Journal of Computer Science & Engineering Survey (IJCSES), 3(6).